脳を構成するニューロン(神経細胞)は、シナプスという接点を通してほかのニューロンとつながっており、それによってネットワークが形成されている。2010年代半ばから進展し、今では社会実装されて大きく貢献しているディープラーニングなどのAIや機械学習の多くは、この生物の脳の構造を参考にして、今から半世紀以上も前に提案された数理モデルの「ニューラルネットワーク」によって実現されている。

脳を模倣しているとはいえ、完全に同じというわけではなく、実際のニューロンやシナプスの動作とニューラルネットワークのそれらとは大きな違いもある。特に違う点として重要視されているのが、現在のニューラルネットワークは「最適化」という緻密な計算によって望ましい機能を実現しているという点だ。それに対して生物のニューロンやシナプスは強い「揺らぎ」を持つ。まるでランダムに、つまり確率的に動作するため、最適化のような緻密な計算をしているようには見えないのである。

ニューラルネットワークの最適化とは、目的の動作を実現するために同ネットワークが持つ変数の値を調整することをいう。この最適化における計算は、膨大なエネルギーを消費してしまうことが大きな課題となっている。ヒトの脳は遥かに少ないエネルギー消費で、現在の最新のスーパーコンピューターでも実現できていない意識を持ち、さらにはさまざまな物事に対応できる柔軟性なども有する。つまり、もしニューラルネットワークも脳のようなランダムに動作するネットワークで高度な情報処理を行えるようになれば、現在よりも遥かに省エネでいて、より柔軟なAIの開発が期待できるという。

ところがその開発は、どのように確率を導入するのかを見極めることが困難であり、確率性の部分的な導入に留まっていた。脳のニューロンとシナプスの性質に整合するニューラルネットワークの構築には成功していなかったのである。

そうした中で、京都大学大学院 情報学研究科の寺前順之介准教授や、立命館大学 情報理工学部の坪泰宏准教授らの共同研究チームは今回、このニューロンやシナプスの揺らぎは邪魔なものではなく、むしろ「揺らぎこそが脳の学習の本質」ではないかと考察。具体的には、揺らぎだけで学習や推論を実現するニューラルネットワークが構成できるのではないかと考え、今回の研究を進めることにしたという。

通常のニューラルネットワークの学習は、ニューロン同士を結びつけるシナプスの強さを、問題に最も合致した1つの値に調整する最適化の過程で実現される。しかしこの最適化の過程は、上述したように生物のニューロンとシナプスが見せるランダムな動作とは一致しない。

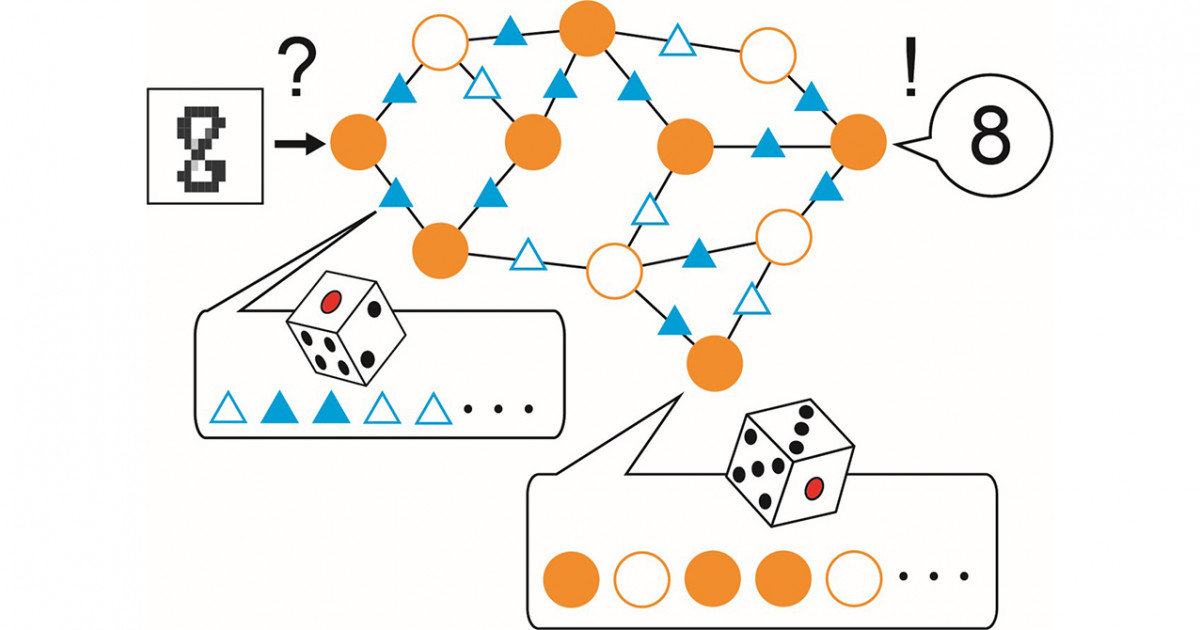

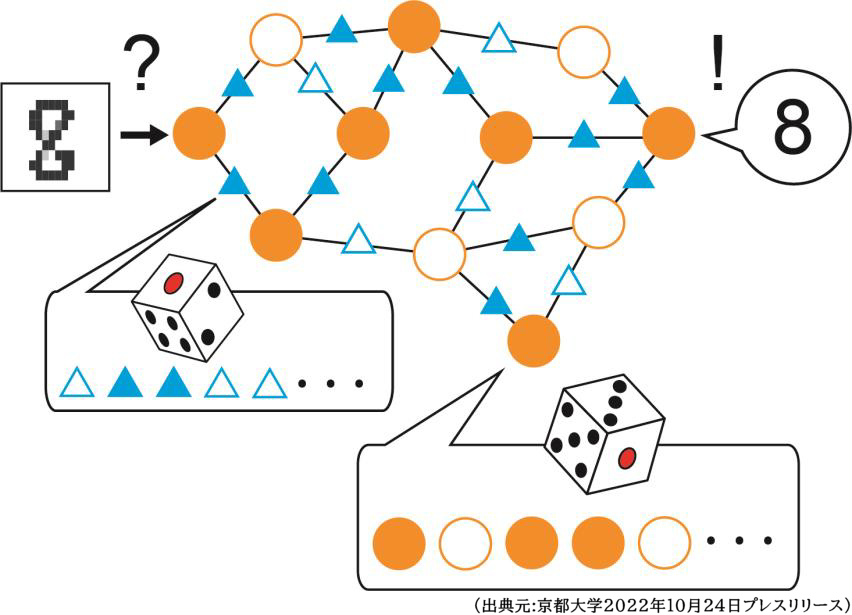

そこで共同研究チームは今回、脳の学習を最適化するのではなく、適切な値の具体例(サンプル)を次々と生み出す過程(サンプリング)ではないかという仮説を立てることにしたとする。この考え方は「ベイズ推定(ベイズ学習)」と呼ばれる理論の1つであり、その中でも特に脳と近い性質を持つと思われた「ギブスサンプリング」の理論を今回は利用することにしたという。その結果、脳のようにランダムなニューロンとシナプスだけで動作するニューラルネットワークの構築が実現した。

こうして構築されたニューラルネットワークは、興味深いことに、動物がものを見たときに脳のニューロンが示す応答の特徴など、生物の脳の揺らぎ以外にも多くの性質を再現できたという。この成果は、現在のニューラルネットワークよりも遥かに低消費電力で動作し、なおかつ柔軟な脳型AIの開発につながるとしている。また確率的な動作を基盤とするため、将来的には量子コンピューターへの応用も可能かもしれないとした。

さらに今回の研究成果は、脳科学や生物学にも大きな波及効果が期待されるという。生物の脳の理解が進むことで、脳の疾患克服にとっても重要な意義を持つことが期待されるとする。今回扱われた学習の仕組みが、実際の脳でも見つかるかどうかの検証実験によって、脳についての新たな知見が得られることが期待されるとした。

揺らぎは、細胞内の情報伝達など、脳以外でも重要な役割を果たしていると考えられている。学習をサンプリングとして捉える今回の理論が、脳以外にも拡張できるかどうかも今後の重要な課題だとしている。

サイエンスライター:波留久泉(D)

(画像出典元:京都大学2022年10月24日プレスリリース)